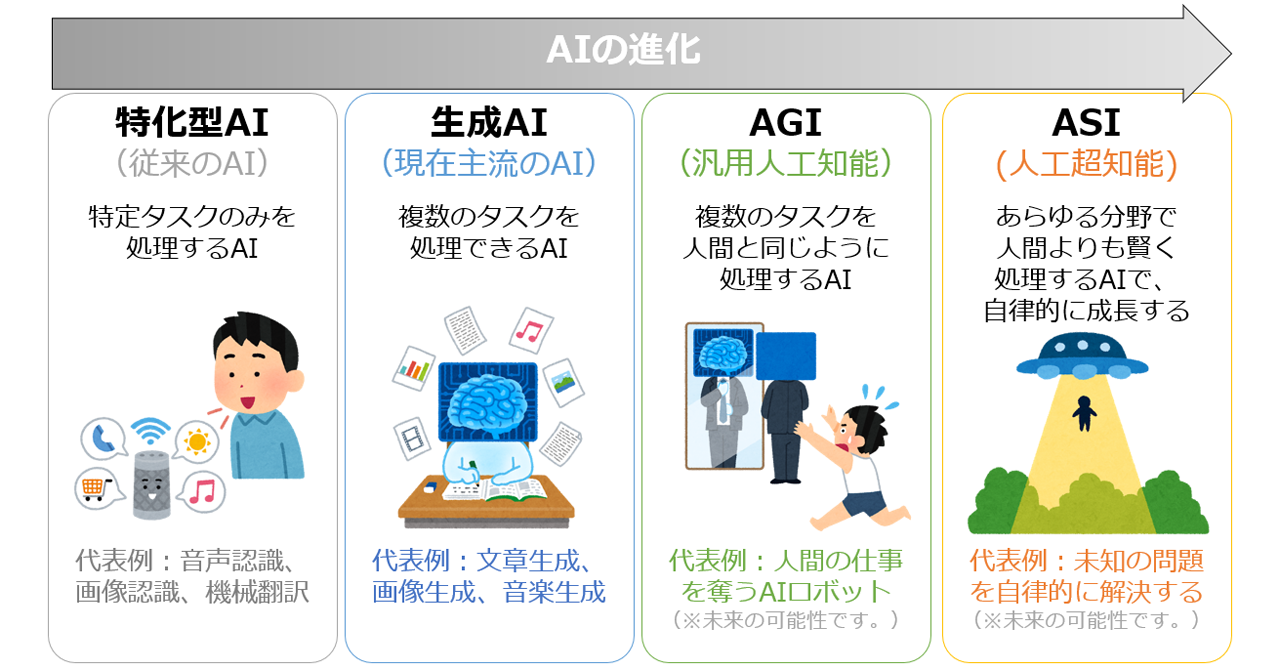

人工超知能(ASI:Artificial Superintelligence)とは?

AGIとの違いAI・機械学習の用語辞典

AIがASIに進化した場合、その制御が人間の手に負えなくなるリスクがある。制御不能に陥った場合、人類に大きな脅威を与える可能性があり、このリスクについての議論が今後ますます重要になると考えられている。

孫正義氏が「安全で素晴らしいAIの未来像」を唱えてもまったく意味ないと思うね😎

「うそつき」と言ってるんじゃないよ😂

https://atmarkit.itmedia.co.jp/ait/spv/2410/09/news018.html